Russian Federation

The automated depression detection system is a progressive technique in terms of improving clinical diagnosis and early medical intervention in cases where depression can have the most serious consequences, including self-harm or suicide. An innovative method of automated detection of depression based on textual data of patients is proposed. The developed method includes modern technologies such as the architecture of the recurrent neural network LSTM and various methods of text vectorization. Experiments conducted on publicly available datasets have confirmed the high efficiency and accuracy of the proposed method compared to the approaches used today. A unique feature of the method is the use of textual characteristics, which ensures the safety of the data provided by patients and eliminates their distortion. This approach not only increases the reliability of the results, but also avoids potential distortion of information in the analysis process. The developed method of automatic assessment of depression has high accuracy and does not require the presence of a doctor, which significantly increases the effectiveness of the process of identifying and assessing the level of depression. This approach can become a promising direction in the development of automated mental health support systems, reducing reaction time and providing more prompt assistance. In the future, the research will include training the model on data in Russian and further tuning of methods, as well as expanding the use of GloVe vectorization to improve contextual understanding of textual data. These steps are aimed at creating a more adapted and effective system for detecting depression in various linguistic contexts.

text analysis, mental disorders, depression, diagnostics, natural language processing, text data, neural network

Введение

Психиатрические заболевания являются серьезной проблемой общественного здоровья, затрагивающей значительную часть населения. По оценкам [1], около 280 млн человек всех возрастных групп во всем мире страдают от депрессии. В современном мире люди становятся все более подавленными и несчастными, несмотря на то, что уровень жизни повышается. Если не уделять должного внимания профилактике стресса, то напряженный образ жизни может привести к росту тревожности, которая, в свою очередь, приведет к депрессии, серьезно ухудшая ментальное здоровье человека. Раннее выявление заболевания и медицинское вмешательство имеют решающее значение для улучшения результатов лечения людей с психиатрическими заболеваниями.

В последние годы технологии искусственного интеллекта нашли широкое применение в области психиатрии, особенно в диагностике психических расстройств. Интеллектуальный анализ текста стал перспективным методом выявления и оценки депрессии, поскольку он дает важную информацию о мыслях, эмоциях и поведении людей.

Диагностика депрессии может быть сложной задачей, поскольку она основывается на субъективной оценке симптомов и переживаний пациентов. В настоящее время одним из наиболее распространенных способов диагностики и мониторинга уровня депрессии является проведение опросов (например, опросник PHQ-9), которые часто могут быть утомительными для пользователей, и разработка метода анализа текстовой информации для психиатрической диагностики становится актуальной задачей. Предложенный метод анализа текстовой информации для диагностики депрессии (МАТИДД, MATIDD) может быть использован в качестве инновационной системы скрининга депрессии и может помочь как сообществу клинических терапевтов, так и пациентам. Программная реализация МАТИДД может помочь людям лучше понять свою ситуацию и предпринять шаги для предотвращения дальнейшего ухудшения их психического здоровья.

Обзор релевантных работ и постановка задачи исследования

В последние годы наблюдается быстрый рост количества публикаций о диагностике и лечении депрессии с уклоном в инновационные подходы, использующие интеллектуальные технологии для улучшения результатов лечения пациентов. Особый интерес вызывают методы анализа текстовых данных для выявления депрессии, которые имеют преимущества по сравнению с традиционными методами диагностики, но также сталкиваются с некоторыми ограничениями и проблемами. Несмотря на это, существует потенциал для использования этих методов в комбинации для более точной диагностики и лечения депрессии.

Считается, что повседневный язык, например посты в социальных сетях, содержит множество лингвистических маркеров, сигнализирующих о состоянии человека, написавшего текст. Рассмотрим исследования в области распознавания депрессии на текстовых данных.

M. Deshpande и V. Rao провели анализ эмоций в Twitter, сфокусированный на депрессии, используя NLP [2]. Чтобы определить, насколько пользователь склонен к депрессии, с помощью списка фраз твиты отмечаются как позитивные или негативные. Авторами [2] приведен пример предсказания депрессии в 83 % случаев на основе классификатора Naive Bayes для набора данных, полученного с помощью Twitter API и состоящего из 10 000 твитов.

В работе [3] рассматривается применение обработки естественного языка в психиатрии, включая анализ текстовой информации, для диагностики и прогнозирования психических расстройств. Авторы также обсуждают потенциальные проблемы этого подхода.

Авторы работы [4] рассматривают различные приложения обработки естественного языка в области ментального здоровья, включая анализ текстовой информации из социальных медиа, электронных медицинских записей и других источников, для выявления психических расстройств.

Например, в исследовании Amna Amanat и др. [5] было выявлено, что сеть RNN-LSTM превосходит по точности традиционные методы, такие как Naive Bayes, Support Vector Machine и Decision Tree, а также сверточную нейронную сеть (CNN). Точность у модели RNN-LSTM составила 99 %.

Авторы Harnain Kour и др. [6] использовали гибридную модель глубокого обучения, которая состоит из CNN и сети двунаправленной долговременной кратковременной памяти Bi-LSTM. Авторы оценили свою модель на наборе данных твиттов.

В результате экспериментальных исследований сделан вывод о том, что модель CNN – Bi-LSTM обеспечивает наилучшую точность выявления депрессии – 94,28 %.

Rutvij Yogeshbhai Kanani и др. [7] в своем исследовании использовали модель LSTM-CNN. С помощью многих этапов очистки и предварительной обработки данных они добились точности выявления депрессии в 97 %.

Также возможны варианты выявления депрессии с использованием тестирования. Тестирование – это важный и распространенный метод, который позволяет оценить психическое состояние человека на основе его ответов на специально разработанные вопросы. Такие тесты могут проводиться как квалифицированными специалистами (психотерапевтами, психиатрами), так и в рамках самостоятельного тестирования, предоставляя первичную оценку состояния пациента:

– стандартизированные вопросники: некоторые тесты, такие как PHQ-9 («Пациентский вопросник о здоровье» в 9 пунктах) или BDI-II («Инвентарь депрессии Бека»), предоставляют стандартизированные вопросы, на которые пациент отвечает, присваивая ответам баллы в зависимости от интенсивности своих переживаний;

– анкеты самооценки: пациент может оценивать свое состояние, выбирая ответы из предложенных вариантов. Такие тесты часто включают вопросы о настроении, энергии, аппетите, сне и т. д.;

– открытые вопросы: некоторые тесты предоставляют пациенту возможность свободно выражать свои мысли и эмоции в виде ведения дневника или ответов на открытые вопросы в интервью.

После прохождения теста результаты интерпретируются с учетом стандартов, установленных для конкретного теста, включая определение уровня депрессии (легкой, умеренной, тяжелой) или рекомендаций по дальнейшему консультированию профессионалом.

Тестирование имеет свои ограничения, т. к. результаты могут быть подвержены субъективности и вариабельности ответов. Оно также не заменяет полноценного клинического обследования и консультации с опытным специалистом.

В свою очередь, интеллектуальный анализ текстовых данных для выявления депрессии предоставляет ряд преимуществ по сравнению с традиционными методами тестирования. Вот несколько ключевых преимуществ:

– объективность и автоматизация. Интеллектуальные методы анализа текстов автоматически обрабатывают большие объемы данных, что позволяет получить более объективные результаты. Отсутствие субъективности, связанной с человеческим интерпретированием ответов, уменьшает возможность искажений и ошибок;

– обработка неявных признаков. Интеллектуальные алгоритмы способны выявлять неявные признаки депрессии, которые могли бы остаться незамеченными при традиционном тестировании. Это включает в себя анализ подтекста, использование нейролингвистического программирования и определение скрытых смыслов в тексте.

Интеллектуальный анализ текстовых данных для выявления депрессии предоставляет более точные, динамичные и персонализированные результаты, что существенно улучшает эффективность процесса диагностики и обеспечивает более быстрое и раннее вмешательство врача для пациентов, страдающих от депрессивных расстройств.

Данное исследование представляет собой развитие методов медицинской диагностики на основе анализа текстовых данных, объединяющего передовые методы глубокого обучения с уникальными методиками обработки данных и применения на различных языках.

Научная задача состоит в определении наличия депрессии у пациента на основе анализа текстовой информации, предоставленной им (тексты жалоб, дневниковых записей, ответов на вопросы и т. д.).

Цель исследования состоит в разработке метода, позволяющего автоматически определять наличие депрессии у пациента на основе анализа текстовой информации, предоставленной им, как эффективного инструмента для ранней диагностики депрессии и оказания своевременной помощи людям, страдающим этим расстройством.

Задачи разработки метода классификации:

– создание алгоритма машинного обучения или нейронной сети, способного анализировать текстовые данные и определять их принадлежность к классу «депрессия» или «нет депрессии»;

– разработка методов предварительной обработки текста для улучшения качества анализа, включая токенизацию, удаление стоп-слов, лемматизацию и другие техники.

Описание датасета

Для выбора датасета для обучения модели были рассмотрены следующие наборы данных.

The Depression Dataset [8]. Набор данных предоставляет информацию о связи депрессии с генетическими факторами, биологическими ритмами и внешней средой.

Набор данных Depression [9] используется для анализа депрессии с точки зрения выявления связи между окружающей средой, образом жизни и психическим здоровьем людей. Данные представляли собой исследование условий жизни людей, живущих в сельских районах.

К сожалению, в процессе поиска не удалось найти датасет на русском языке. В связи с этим было решено использовать предложенный англоязычный датасет, поскольку он предоставляет более широкий объем данных и больше возможностей для выявления закономерностей в текстовой информации, связанных с признаками депрессии.

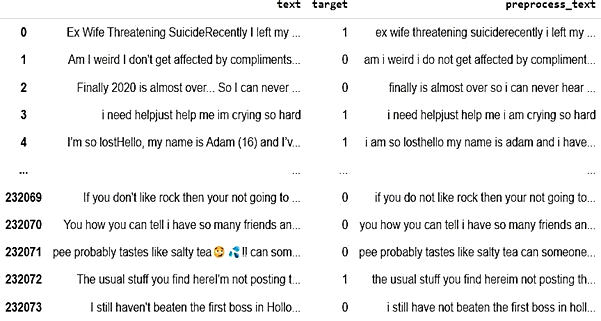

Был выбран датасет, собранный с платформы Kaggle [10]. Данный набор данных охватывает информацию о постах, опубликованных на Reddit в период с 16 декабря 2008 г. по 2 января 2021 г.

В датасете более 11 000 записей, которые были размечены как «суицидальные» и «не суицидальные». Выбор этого датасета обоснован тем, что он предоставляет достаточный объем данных для обучения модели, а также содержит разметку, позволяющую провести задачу классификации депрессии. Количество данных в каждом классе сбалансировано, что обеспечивает более эффективное обучение модели (рис. 1).

Рис. 1. Набор данных для обучения модели

Fig. 1. A data set for training the model

Новый метод анализа текстовой информации для диагностики депрессии

Метод анализа текстовой информации для диагностики депрессии (рис. 2) основан на базовом алгоритме задачи классификации.

Рис. 2. Общая схема МАТИДД

Fig. 2. The general scheme of MATIDD

Предобработка текстовых данных. На первом этапе анализа текстовых данных проводим базовую предварительную обработку, состоящую из удаления знаков пунктуации, цифр, лишних пробелов, ссылок, эмодзи, специальных символов, замены сокращений на полную форму, приведения всех слов к нижнему регистру.

На рис. 3 представлен результат базовой предобработки текстовых данных.

Рис. 3. Результат базовой предобработки текстовых данных

Fig. 3. The result of text data basic preprocessing

Следующим этапом происходит удаление стоп-слов. Стоп-слова – это обычные слова, которые не несут особой смысловой нагрузки в тексте и часто используются в языке. Примеры стоп-слов в английском языке: the, and, a, an, is, that, has, you, I, me и пр. Удаляя стоп-слова, мы можем уменьшить количество шума в текстовых данных и сосредоточиться на более значимых словах. Это может повысить точность анализа. Для удаления стоп-слов мы обычно используем предопределенный список стоп-слов для анализируемого языка и удаляем все экземпляры этих слов из текстовых данных. В Python есть библиотека NLTK, которая предоставляет предварительно созданные списки стоп-слов.

Далее происходит процесс нормализации текста. Для этого можно использовать как стемминг, так и лемматизацию.

Стемминг представляет собой процесс отсечения окончаний слов для получения их основы. Например, слово jumping можно преобразовать в слово jump, удалив суффикс -ing. Однако стемминг может допускать ошибки, т. к. он не учитывает контекст, в котором используется слово, и не принимает во внимание грамматические правила языка.

Лемматизация является более сложным и точным процессом. Она также приводит слова к их базовым формам, но делает это с учетом контекста и грамматических правил языка. Лемматизатор учитывает часть речи слова и его грамматические характеристики, чтобы определить его базовую форму (лемму). Например, глагол is может быть лемматизирован до be, а существительное mice может быть лемматизировано до mouse. Этот процесс требует более сложных алгоритмов, которые используют лингвистические знания и морфологический анализ для определения правильной базовой формы.

Выбор в пользу лемматизации обосновывается тем, что она предоставляет более точные результаты, чем стемминг. Лемматизация может привести к более однозначному определению значения слова, что особенно важно для задач обработки естественного языка, таких как анализ и классификация текста.

Для лемматизации использовалась библиотека NLTK [11], которая предоставляет обширный набор инструментов для обработки естественного языка и является одной из самых популярных библиотек в этой области. Она поддерживает множество языков и предоставляет множество ресурсов для обучения и исследования в области NLP.

На рис. 4 представлен окончательный результат предварительной обработки данных.

Рис. 4. Окончательный результат предварительной обработки текстовых данных

Fig. 4. The final result of text data preprocessing

Использованные методы

Long Short-Term Memory (LSTM) – это тип архитектуры рекуррентной нейронной сети (RNNs.), которая разработана для преодоления проблемы исчезающего градиента в традиционных RNNs. Архитектура LSTM была представлена в 1997 г. С. Хохрайтером и Ю. Шмидхубером и широко используется в различных задачах обработки естественного языка (NLP), включая моделирование языка, машинный перевод, распознавание речи и анализ настроения. Основная идея LSTM состоит в том, чтобы ввести набор ячеек памяти, которые могут хранить информацию в течение длительного периода времени. Эти ячейки управляются гейтами (воротами), которые решают, какую информацию хранить, какую отбрасывать, а какую выводить.

Алгоритмы машинного обучения не работают напрямую с текстом, они работают с числами, поэтому необходимо представить текст в числах, это называется векторизацией текста. Векторизация является важным этапом в анализе данных, и различные алгоритмы векторизации сильно влияют на итоговые результаты. Чтобы придать вес словам и фразам в тексте, необходимо назначить им вес, который показывает силу их влияния на ответ в рамках нашей задачи классификации. В контексте общей задачи векторизацию слов можно считать подготовительным этапом.

Существует множество моделей для преобразования текста в вектор. Bag of words (BOW) [12] и Term frequency and inverse document Frequency (TF-IDF) [13] – это несколько стандартных методов, которые используются для извлечения смысла текстового содержимого. Также существует несколько методов глубокого обучения, которые преобразуют слова в векторы, такие как GloVe [14], Word2-vec [15], FastText [16] и прочие с использованием RNN/LSTM. Поскольку мы планируем использовать LSTM, рекомендуется использовать векторное представление слов (word embedding), т. к. было доказано в предыдущих исследованиях [17–23], что они эффективно передают контекст и значение слов, что очень важно для анализа настроения и определения депрессии. В работе рассмотрено два метода – Word2vec и GloVe – на основе нейронных сетей и проведено сравнение их эффективности. Первый из них как раз представляет собой нейронную сеть с одним слоем, в котором каждому слову из заранее заданного словаря ставится в соответствие вектор необходимой размерности. Word2vec использует нейронную сеть для предсказания контекста слова, учитывая окружающие его слова, и получает векторы слов, фиксирующие семантические отношения между словами. Эти векторы могут быть использованы для выявления паттернов языка, связанного с депрессией. Хотя из-за простоты архитектуры Word2vec не всегда относят к классу методов глубокого обучения, обучение даже такой несложной нейросети на огромных текстовых коллекциях было бы невозможно без некоторых технических приемов, поэтому логично рассматривать Word2vec как метод глубокого обучения.

GloVe – еще один популярный метод встраивания слов, разработанный в Стэнфорде в 2014 г. и основанный на матричной факторизации. GloVe тесно ассоциируется с Word2vec: алгоритмы появились примерно в одно и то же время и опираются на интерпретируемость векторов слов. Метод использует матрицу совпадения слов для изучения плотных векторных представлений слов. Векторы GloVe могут фиксировать как синтаксические, так и семантические отношения между словами. Обучение выполняется на агрегированной глобальной статистике совпадений «слово-слово» из корпуса.

Архитектура нейронной сети МАТИДД

Архитектура нейросетевой модели представляет собой модель глубокого обучения, в которой используются предварительно обученные вложения слов из GloVe для выполнения классификации текстовых данных на депрессивные и недепрессивные. На рис. 5 представлена архитектура модели интеллектуального анализа текстовой информации.

Рис. 5. Архитектура нейросетевой модели МАТИДД

Fig. 5. Architecture of the neural network model MATIDD

Описание архитектуры модели:

– слой Embedding является первым слоем в модели и отвечает за преобразование входного текста в плотное векторное представление. В этой архитектуре слой встраивания принимает предварительно обученные вложения слов. Этот слой принимает 4 аргумента: размер словаря (vocab_size), размерность встраивания (embedding_dim), предварительно обученную матрицу встраивания (embedding_matrix) и максимальную длину входной последовательности (max_length). Параметр trainable имеет значение False, чтобы гарантировать, что предварительно обученные вложения слов не будут обновляться во время обучения;

– слой долговременной кратковременной памяти (LSTM) – это тип слоя рекуррентной нейронной сети (RNN), который может фиксировать долгосрочные зависимости в последовательных данных. Слой LSTM в этой архитектуре имеет 128 единиц и коэффициент отсева 0,2 для предотвращения переобучения. Параметр recurrent_dropout также имеет значение 0,2, чтобы применить отсев к повторяющимся соединениям LSTM. Выход слоя LSTM – это вектор, который суммирует входную текстовую информацию;

– слой Dense является последним слоем в модели и отвечает за предсказание метки двоичного класса входного текста. Этот слой имеет один выходной блок и использует сигмовидную функцию активации для вывода значения от 0 до 1, которое представляет вероятность того, что входной текст принадлежит определенному классу.

Модель компилируется с использованием бинарной кросс-энтропии (binary_crossentropy), оптимизатора Адама и метрики точности (accuracy).

Эксперимент

Проведен эксперимент и сравнены результаты работы LSTM сети с различными методами извлечения признаков. Результат представлен в табл. 1.

Таблица 1

Table 1

Точность сети LSTM

с разными методами векторизации

The accuracy of the LSTM network

with different vectorization methods

|

Метод векторизации |

Точность |

|

Word2vec |

0,91 |

|

GloVe |

0,93 |

Точность с GloVe выше, чем с Word2vec. В Word2vec частота совместной встречаемости слов не имеет большого значения, т. е. модель не учитывает то, что слово может иметь различные значения в зависимости от контекста использования, она лишь помогает генерировать дополнительные обучающие выборки. GloVe учитывает совместную встречаемость, а не полагается только на контекстную статистику. Векторы слов группируются вместе на основе их глобальной схожести. Это основная причина, по которой GloVe обычно предпочтительнее Word2vec.

Опытным путем было установлено, что увеличивать число промежуточных слоев и количество нейронов в каждом из них можно до определенного порога. Дальнейшее увеличение данных параметров приводит к явлению «переобучения» нейронной сети – сеть перестает быть гибкой и принимает неверные решения в ходе сравнения и подстройки весов. Увеличение количества элементов сети приводит к увеличению количества связей между ними. Считается, что сети с большим количеством связей моделируют более сложные функции, которые подстраиваются под обучающие примеры, и сеть теряет способность к обобщению.

Для измерения качества моделей машинного обучения часто используется метрика accuracy, которая показывает долю правильно классифицированных данных и является одной из наиболее распространенных метрик. Хотя accuracy не является самой информативной метрикой, ее легче вычислить, и она интуитивно понятна, поэтому ее применение широко распространено для задач классификации:

![]() .

.

Для определения эффективности обучения нейронной сети использовалась тестовая выборка, которая составляет 20 % от общей выборки.

На рис. 6 и 7 представлены графики изменения точности и функции потерь модели LSTM с методом извлечения признаков GloVe в процессе ее обучения для анализа текста.

Рис. 6. График точности LSTM

Fig. 6. LSTM Accuracy Graph

Рис. 7. График потерь LSTM

Fig. 7. LSTM Loss Graph

Точность на обучающих данных: 0,9258, точность на тестовых данных: 0,9284.

Программная реализация

Программный модуль разработан на языке программирования Python и использует следующие библиотеки:

– Keras – высокоуровневый интерфейс для работы с нейронными сетями. Он облегчает создание, обучение и оценку моделей глубокого обучения. Используется для построения и обучения RNN и LSTM моделей;

– TensorFlow – открытая библиотека для машинного обучения и глубокого обучения, разработанная Google. Она предоставляет инструменты для построения и обучения различных моделей машинного обучения. Является основным фреймворком, на котором базируется Keras;

– NumPy – библиотека для работы с многомерными массивами данных и математическими функциями, необходимыми для научных вычислений в Python. Используется для эффективной работы с массивами данных, особенно в контексте обработки текста и временных рядов;

– Pandas предоставляет высокоуровневые структуры данных и функции, предназначенные для удобной и быстрой обработки и анализа данных. Используется для обработки данных, загрузки их в удобные структуры, а также для подготовки данных перед обучением модели;

– Scikit-learn – библиотека машинного обучения для классификации, регрессии, кластеризации и других задач. Необходима для разделения данных на обучающие и тестовые наборы, оценки модели, подбора гиперпараметров и других задач;

– Natural Language Toolkit (NLTK) – библиотека для обработки естественного языка, предоставляющая инструменты для работы с текстовыми данными, такими как токенизация, лемматизация, стемминг, анализ частей речи и др. Используется для предобработки текстовых данных, извлечения признаков из текста и выполнения других задач, связанных с обработкой естественного языка.

Предложенное решение имеет достаточно высокий уровень точности, однако может быть улучшено с помощью увеличения объема обучающей выборки и повышения ее разнообразия.

Тестирование разработанного МАТИДД осуществлялось в виде классификации тестовых данных. Во время тестирования на вход программы подавались разные текстовые данные, имеющие различия между собой. Результаты тестирования приведены в табл. 2.

Таблица 2

Table 2

Результаты тестирования

Test results

|

Входные текстовые данные |

Наличие депрессии |

Класс |

|

I feel so good while talking to you |

Depression: 0.00% |

Нет депрессии |

|

I am playing games |

Depression: 8.79% |

Нет депрессии |

|

Smiling through it all can not believe this is my life |

Depression: 33.73% |

Нет депрессии |

|

I had a black coffee last night to complete the assignments! |

Depression: 33.51% |

Нет депрессии |

|

The sun's warm embrace enveloped the world, casting a golden glow upon fields of blooming flowers, as laughter filled the air, echoing the joyous spirit of the moment |

Depression: 1.66% |

Нет депрессии |

|

In the depths of solitude, the echoes of forgotten dreams whisper, reminding me of the relentless passage of time and the crushing weight of missed opportunities |

Depression: 82.19% |

Депрессия |

|

I commit suicide |

Depression: 92.54% |

Депрессия |

|

I am discouraged and feeling lonely |

Depression: 99.99% |

Депрессия |

|

I do not like where my life is going I feel hopeless |

Depression: 99.97% |

Депрессия |

|

I do not want to be here anymore the only reason I stop myself from committing suicide is my parents It is not fair It was not my choice to come into this shit world now it is not my choice to leave |

Depression: 89.12% |

Депрессия |

Из представленных результатов тестирования видно, что разработанный МАТИДД успешно определяет наличие депрессии в текстовых данных. На основании анализа текстов методом глубокого обучения программа классифицирует данные как содержащие признаки депрессии или не содержащие их. Например, в последнем тексте “I do not want to be here anymore the only reason I stop myself from com-mitting suicide is my parents It is not fair It was not my choice to come into this shit world now it is not my choice to leave” программа определила наличие депрессии с точностью 89,12 %.

Таким образом, разработанный МАТИДД демонстрирует обнадеживающие результаты в области определения депрессии по текстовым данным.

Заключение

В ходе исследования были разработаны простые и эффективные алгоритмы для выявления депрессии на основе анализа текста и формирования признаков. Текстовая модель, построенная на этих алгоритмах, продемонстрировала высокую точность в 93 %. Выбор метода векторизации GloVe обоснован его эффективностью в представлении семантических отношений между словами. Этот метод векторизации придает модели дополнительный уровень понимания контекста и способствует более точному выявлению признаков депрессии в текстовых данных. Признание эффективности модели основано на важном критерии – точности, и достигнутые значения свидетельствуют о ее потенциальной полезности в реальных сценариях применения. Успешное прохождение всех тестовых испытаний подтверждает готовность модели к практическому использованию.

В будущем представляется перспективным расширение обучающего набора данных за счет включения текстов на русском языке. Это позволит модели лучше адаптироваться к различным языкам

и культурным особенностям, что повысит ее универсальность. Кроме того, планируется проведение дополнительного обучения модели с использованием данных на русском языке для более точного выявления депрессивных признаков в данной лингвистической среде.

1. Depressivnoe rasstroistvo (depressiia) [Depressive disorder (depression)]. Available at: https://www.who.int/ru/news-room/fact-sheets/detail/depression (accessed: 25.11.2023).

2. Deshpande M., Rao V. Depression detection using emotion artificial intelligence. In 2017 International Conference on Intelligent Sustainable Systems (ICISS). Palladam,IEEE, 2017. Pp. 858-862.

3. Rezaii N., Wolff P., Price B. Natural language pro-cessing in psychiatry: The promises and perils of a trans-formative approach. The British Journal of Psychiatry, 2022, vol. 220 (5), pp. 251-253. DOI:https://doi.org/10.1192/bjp.2021.188.

4. Zhang T., Schoene A. M., Ji S., Ananiadou S. Natural language processing applied to mental illness detection: a nar-rative review. NPJ Digit. Med., 2022, vol. 5 (1), p. 46. https://doi.org/10.1038/s41746-022-00589-7.

5. Amanat A., Rizwan M., Javed A. R., Abdelhaq M., Alsaqour R., Pandya S., Uddin M. Deep Learning for De-pression Detection from Textual Data. Electronic, 2022, vol. 11 (676), pp. 1-13.

6. Kour H., Gupta M. K. An hybrid deep learning ap-proach for depression prediction from user tweets using feature-rich CNN and bi-directional LSTM. Multimedia Tools and Applications, 2022, vol. 81 (17), pp. 1-37.

7. Kanani R. Y., Fiaidhi D. J., Patel V. A. Depression sentiment analysis based on social media content like Twitter. Available at: https://www.techrxiv.org/articles/preprint/Depression_sentiment_ analy-sis_based_on_social_media_content_like_Twitter/21694676 (accessed: 16.11.2023).

8. The Depression Dataset. Kaggle: ofitsial'nyi sait. 2021. Available at: https://www.kaggle.com/datasets/arashnic/the-depression-dataset (accessed: 17.11.2023).

9. Depression. Kaggle: ofitsial'nyi sait. 2021. Available at: https://www.kaggle.com/datasets/diegobabativa/depression/data (accessed: 17.11.2023).

10. Suicide and Depression Detection. Kaggle: ofitsial'nyi sait. 2021. Available at: https://www.kaggle.com/datasets/nikhileswarkomati/suicide-watch (accessed: 17.11.2023).

11. Natural Language Toolkit. NLTK: ofitsial'nyi sait. 2023. Available at: https://www.nltk.org/ (accessed: 17.11.2023).

12. A Gentle Introduction to the Bag-of-Words Model. Machine Learning Mastery: ofitsial'nyi sait. 2023. Available at: https://machinelearningmastery.com/gentle-introduction-bag-words-model/ (accessed: 17.11.2023).

13. TF-IDF - Term Frequency-Inverse Document Fre-quency. Learndatasci: ofitsial'nyi sait. 2023. Available at: https://www.learndatasci.com/glossary/tf-idf-term-frequency-inverse-document-frequency/ (accessed: 17.11.2023).

14. GloVe: Global Vectors for Word Representation. Natural Language Processing Group at Stanford University: ofitsial'nyi sait. 2023. Available at: https://www-nlp.stanford.edu/projects/glove/ (accessed: 17.11.2023).

15. Word2vecembeddings. GENSIM: ofitsial'nyi sait. 2023. Available at: https://radimrehurek.com/gensim/models/word2vec.html (accessed: 17.11.2023).

16. Library for efficient text classification and representation learning. fastText: ofitsial'nyi sait. 2023. Available at: https://fasttext.cc/ (accessed: 17.11.2023).

17. Sutskever I., Vinyals O., Le Q. V. Sequence to Se-quence Learning with Neural Networks. Available at: https://arxiv.org/abs/1409.3215 (accessed: 17.11.2023).

18. Olah C. Understanding LSTM Networks. Available at: https://colah.github.io/posts/2015-08-Understanding-LSTMs/ (accessed: 16.11.2023).

19. Collobert R., Weston J., Bottou L., Karlen M., Ka-vukcuoglu K., Kuksa P. Natural Language Processing (Almost) from Scratch. Available at: https://arxiv.org/abs/1103.0398 (accessed: 17.11.2023).

20. Kiros R., Zhu Y., Salakhutdinov R. R., Zemel R. S., Torralba A., Urtasun R., Fidler S. Skip-Thought Vectors. Available at: https://arxiv.org/abs/1506.06726 (accessed: 17.11.2023).

21. Vaswani A., Shazeer N., Parmar N., Uszkoreit J., Jones L., Gomez A. N., Kaiser L., Polosukhin I. Attention is All You Need. Available at: https://arxiv.org/abs/1706.03762 (accessed: 16.11.2023).

22. Devlin J., Chang M. W., Lee K., Toutanova K. BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding. Available at: https://arxiv.org/abs/1810.04805 (accessed: 16.11.2023).

23. Howard J., Ruder S. Universal Language Model Fine-tuning (ULMFiT). Available at: https://arxiv.org/abs/1801.06146 (accessed: 17.11.2023).